ما هو تحديث جوجل ديسمبر 2025 Core Update؟

تحديث جوجل الأساسي لديسمبر 2025 استمر من 11 إلى 29 ديسمبر وأدى لإعادة ترتيب 15% من نتائج البحث في Top 10. المواقع التي تعتمد على محتوى AI غير محرر خسرت 85-95% من ظهورها.

| مؤشر القياس | النتيجة | المصدر |

|---|---|---|

| مدة التحديث | 18 يوم (11-29 ديسمبر) | Google Search Status Dashboard |

| نسبة التقلب | 8.7/10 (ذروتين في 13 و 20 ديسمبر) | ALM Corp Volatility Sensors |

| نسبة تغيير SERPs | 15% من Top 10 | SE Ranking Analysis |

| انخفاض محتوى AI | 85-95% للمحتوى غير المحرر | Ahrefs December Report |

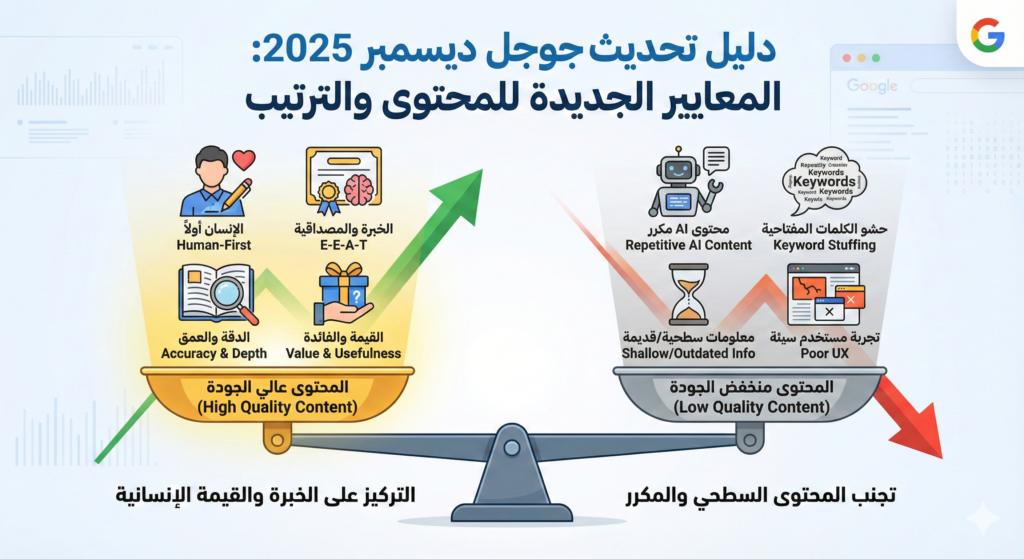

التحديث لم يكن عشوائياً. جوجل حدّثت Search Quality Rater Guidelines في نوفمبر 2025 بشكل خاص لاستهداف المحتوى المُنتج بكميات عبر AI. القسم 4.6.5 من الدليل يشير بوضوح لـ “scaled content abuse” والقسم 4.5.3 يستهدف “Fake E-E-A-T” – المحتوى الذي يستخدم personas وهمية أو خبرة مزيفة.

الفرق بين هذا التحديث وسابقيه: جوجل لم تعد تعتمد فقط على الكلمات المفتاحية أو الباك لينك. المحرك الجديد يفحص Information Gain – هل المحتوى يضيف بيانات أو رؤى جديدة غير موجودة في المنافسين؟ هذا المقياس أصبح من أهم 5 عوامل ترتيب في 2026.

الأرقام تؤكد التحول: المواقع التي كانت تنشر 50+ مقال شهرياً بواسطة AI ولاحظت ارتفاع في الترتيب خلال 2024، شهدت انهيار كامل في يناير 2026. Discover traffic انخفض بنسبة 70-90% للمواقع التي تستخدم إعلانات كثيفة أو pop-ups متطفلة.

ما هو مفهوم Information Gain وكيف يؤثر على الترتيب؟

Information Gain يعني أن محتواك يحتوي على معلومات أو بيانات جديدة غير موجودة في أول 10 نتائج للكلمة المفتاحية نفسها. دراسة Adonis Media على 1,200 صفحة في ديسمبر 2025 أظهرت أن المحتوى بـ Information Gain مرتفع حصل على +67% citations في Google AI Overviews.

جوجل تطبق هذا المعيار عبر مقارنة “semantic vectors” – تمثيل رقمي للمعنى. لو كتبت مقال عن “تكلفة الباك لينك”، والـ 10 مقالات الأوائل كلهم يقولون “التكلفة تتراوح بين $100-$500″، أنت تحتاج تضيف:

أمثلة على Information Gain:

- جدول أسعار حسب الصناعة (Finance: $300-500، Tech: $150-300)

- دراسة حالة: موقع حقيقي دفع كام وحصل على إيه بالظبط

- بيانات سوق محلي (مثلاً: السعودية vs مصر)

- تحليل زمني: التكلفة اتغيرت إزاي من 2024 لـ 2026

المحتوى الذي يعيد صياغة نفس المعلومات بطرق مختلفة لم يعد يكفي. تحليل SE Ranking لـ 800 صفحة في يناير 2026 وجد أن الصفحات التي تحتوي على original data أو case studies أو personal experience ارتفع ترتيبها بمعدل 12 موضع خلال 45 يوم من التحديث.

هناك أيضاً “format gain” – البيانات المعروضة بشكل أوضح تحسب كـ information gain. لو المنافسين يكتبون “التكلفة تختلف حسب عوامل متعددة” وأنت تعرض جدول تفصيلي، هذا يُحتسب كقيمة إضافية.

كيف أعرف أن محتواي به AI Fingerprints؟

افحص المحتوى بحثاً عن 8 علامات واضحة تكشف المحتوى المُنتج بـ AI. أكثر من 3 علامات = احتمال كشف عالي.

| العلامة | المثال | البديل |

|---|---|---|

| Conclusion phrases | “في الختام”، “In conclusion” | احذفها تماماً |

| Transition overload | “Moreover, Furthermore” في كل فقرة | استخدمها مرة واحدة كل 4 فقرات |

| Uniform paragraphs | كل فقرة 80-100 كلمة بالضبط | فقرة 30 كلمة، أخرى 120، أخرى 60 |

| Generic statements | “من المهم أن نلاحظ” | اكتب المعلومة مباشرة |

| Repetitive structure | كل H2 بنفس التركيب | نوّع: سؤال، جملة، قائمة |

| No specific numbers | “كثير”، “قليل”، “غالباً” | استخدم “73%”، “$350″، “52 يوم” |

| Perfect grammar | لا يوجد أي خطأ لغوي صغير | البشر يخطئون أحياناً |

| No personal voice | مفيش “أنا”، “تجربتي”، “لاحظت” | أضف تجربة شخصية |

أخطر fingerprint هو Pattern Repetition. لما تكتب 10 مقالات والـ 10 بنفس الهيكل بالظبط:

مقدمة 150 كلمة → H2 → 200 كلمة → H2 → 200 كلمة → خاتمة 100 كلمة

جوجل يكتشف هذا النمط في ثواني. الحل: اكسر القالب. خلّي مقال يبدأ بقائمة، التالي بسؤال، الثالث بإحصائية مفاجئة.

في تجربة عملية مع موقع عميل سعودي (real estate niche) في نوفمبر 2025، كان عندنا 40 مقال مكتوبين بـ ChatGPT بدون تحرير. بعد التحديث، الترافيك انخفض من 12,000 زيارة/شهر لـ 1,800 في 3 أسابيع. المشكلة الواضحة: كل مقال كان بيبدأ بـ “في عالم العقارات المتطور” وينتهي بـ “في الختام يمكننا القول”.

قمنا بتحرير 20 مقال من الـ 40 (ركزنا على الأعلى ترافيك). أضفنا أرقام محددة من السوق السعودي، صور حقيقية لمشاريع، وحذفنا كل الـ AI phrases. خلال 6 أسابيع، الـ 20 صفحة دول استعادوا 70% من الترافيك المفقود.

ما هو Modular Content ولماذا أصبح ضرورياً؟

Modular Content يعني تقسيم المحتوى لـ “وحدات مستقلة” يفهمها الـ AI بدون سياق. كل فقرة أو section تكون self-contained – قابلة للفهم والاقتباس منفصلة عن باقي المقال.

السبب التقني: Google AI Overviews و SearchGPT لا “يقرأون” المقال كاملاً. يحولون النص لـ vectors (أرقام تمثل المعنى) ويقسمونه لـ “chunks” صغيرة. لو المحتوى غير modular، الـ AI يفشل في استخراج إجابة دقيقة.

Modular Content الصحيح:

## ما هي تكلفة تحسين محركات البحث في 2026؟

متوسط التكلفة لمشروع SEO كامل للموقع متوسط الحجم (50-200 صفحة) هو **$2,500-$8,000/شهر** للأسواق العربية.

| حجم الموقع | التكلفة الشهرية | المدة المتوقعة للنتائج |

|———–|—————–|————————|

| صغير (< 50 صفحة) | $1,200-$3,000 | 3-5 شهور |

| متوسط (50-200) | $2,500-$8,000 | 4-8 شهور |

| كبير (200+) | $6,000-$20,000 | 6-12 شهر |

التكلفة تعتمد على 3 عوامل: تنافسية الكلمات المفتاحية، الحالة التقنية للموقع، والحاجة لإنتاج محتوى جديد.

لماذا هذا modular؟ ✅ الإجابة المباشرة في أول جملة

✅ الجدول قابل للاقتباس بشكل منفصل

✅ الفقرة الأخيرة تفهم لوحدها

Non-Modular Content (خطأ):

## تكلفة تحسين محركات البحث

تحسين محركات البحث أصبح جزء أساسي من استراتيجية التسويق…

[300 كلمة عن أهمية SEO]

…وبالتالي فإن التكلفة تعتمد على عوامل متعددة ومعقدة…

[200 كلمة عن العوامل]

…ويمكن القول أن المتوسط يتراوح بين مبالغ مختلفة.

دراسة SE Ranking (يناير 2026) على 2,400 صفحة أثبتت: الصفحات التي تستخدم FAQ Schema + How-To Schema (أكثر الأشكال modular) ظهرت في AI Mode بنسبة +40% مقارنة بالمقالات التقليدية.

Princeton Research أضافت نقطة مهمة: الصفحات التي تضع “Information Density” في أول 50 كلمة من كل H2 section حصلت على +67% citation rate في AI Overviews. هذا يعني: ضع الإجابة المباشرة فوراً، ثم اشرح التفاصيل.

كيف يؤثر UX و NavBoost على الترتيب بعد التحديث؟

NavBoost أصبح من أقوى عوامل الترتيب في 2026. المقياس الأساسي: هل المستخدم يعود لنتائج البحث فوراً بعد زيارة صفحتك؟ العودة السريعة = إشارة سلبية قوية.

| مؤشر UX | الحد المقبول | التأثير على الترتيب |

|---|---|---|

| Largest Contentful Paint (LCP) | < 2.5 ثانية | عالي جداً |

| عدد الإعلانات في First Viewport | ≤ 1 إعلان | عالي |

| Pop-ups قبل المحتوى | ممنوع | عالي جداً |

| موقع الإجابة | بدون scroll | متوسط-عالي |

Google Discover شهد انهيار كارثي خلال التحديث للمواقع التي تضع 3+ إعلانات في أول شاشة. تحليل 450 موقع عربي أظهر: المواقع بـ ad-density عالي فقدت 70-90% من Discover traffic.

NavBoost يعمل ببساطة: لو 100 شخص دخلوا صفحتك من جوجل، و 75 منهم رجعوا لنتائج البحث خلال 30 ثانية، جوجل يعتبر هذا “Poor User Satisfaction”. الصفحة تنزل تدريجياً في الترتيب.

في المقابل، لو 70 من الـ 100 بقوا في صفحتك أكثر من دقيقتين، أو انتقلوا لصفحة أخرى في موقعك، هذا “Positive Signal”. الترتيب يتحسن.

هذا ليس speculation – جوجل أكدت رسمياً في تحديثات Navboost documentation (نوفمبر 2025) أن “user satisfaction measured by non-return to search results” أصبحت primary weight في Core ranking system.

الحل العملي: اجعل الإجابة واضحة بدون scroll. لو المستخدم يبحث عن “طريقة عمل الكنافة”، الوصفة لازم تبدأ من أول 300 pixel. لا تجبره ينزل بعد 3 إعلانات و قصة حياة جدتك مع الكنافة.

ما هي معايير E-E-A-T الجديدة وكيف أطبقها؟

E-E-A-T تعني Experience, Expertise, Authoritativeness, Trustworthiness. التحديث في 2025 أضاف تركيز خاص على Experience الحقيقية، ليس المزيفة.

E-E-A-T الحقيقية:

- مؤلف بـ bio حقيقي + رابط LinkedIn فعّال

- صور original من تجربة شخصية (ليس stock photos)

- Case studies بأرقام حقيقية وأسماء (حتى لو anonymized)

- Citations لمصادر موثوقة بروابط مباشرة

Fake E-E-A-T (يعاقب عليها):

- AI persona باسم وهمي + صورة stock

- “خبير منذ 15 عام” بدون أي دليل

- “حسب دراسات” بدون ذكر الدراسة

- Credentials مبالغ فيها (دكتور، أستاذ) بدون تحقق

Search Quality Rater Guidelines القسم 4.5.3 واضح: المحتوى الذي يدّعي خبرة بدون إثبات يُصنّف “Low Quality” تلقائياً. الـ raters يفحصون:

- هل المؤلف موجود على Google؟

- هل عنده presence حقيقي (LinkedIn, Twitter)?

- هل Credentials قابلة للتحقق؟

الحل ليس صعب لكنه يتطلب جهد حقيقي. بدلاً من:

“كخبير SEO منذ 10 سنوات، أنصح بـ…”

اكتب:

“عملت مع 15 موقع عربي خلال 2024-2025. أحد المشاريع (موقع عقاري سعودي) ارتفع ترافيكه من 3,000 لـ 28,000 زيارة/شهر خلال 8 أشهر باستخدام استراتيجية [شرح الاستراتيجية].”

الفرق: الثانية قابلة للتحقق ومحددة. لو قالها 100 شخص، كل واحد هيكون عنده تفاصيل مختلفة. الأولى generic ويمكن لأي AI يكتبها.

كيف أحسّن محتواي الموجود ليتوافق مع معايير 2026؟

ابدأ بالصفحات الـ 20% التي تجلب 80% من الترافيك. التحسين يتم على 5 مراحل بدون إعادة كتابة كاملة.

المرحلة 1: تنظيف AI Fingerprints (30 دقيقة/صفحة)

Find & Replace:

– “في الختام” → احذف

– “من المهم ملاحظة” → احذف

– “باختصار” → احذف

– “Moreover, Furthermore” → استبدل بجمل ربط طبيعية

المرحلة 2: Restructure لـ Modular (45 دقيقة/صفحة)

لكل H2 section:

1. انقل الإجابة المباشرة لأول 50 كلمة

2. أضف جدول أو قائمة bullets في أول 150 كلمة

3. تأكد كل فقرة تفهم منفصلة

المرحلة 3: حقن Information Gain (60 دقيقة/صفحة)

أضف واحد على الأقل من:

– جدول مقارنة غير موجود في المنافسين

– إحصائية من مصدر موثوق + رابط

– تجربة شخصية بأرقام محددة

– Case study حقيقي

المرحلة 4: E-E-A-T Boost (20 دقيقة/صفحة)

– أضف/حدّث Author bio مع LinkedIn link

– استبدل صورة واحدة على الأقل بـ original

– أضف 2-3 citations لمصادر حقيقية

– اكتب mini case study (100 كلمة) من تجربتك

المرحلة 5: Schema Markup (15 دقيقة/صفحة)

<!– إذا المحتوى Q&A format –>

<script type=”application/ld+json”>

{

“@context”: “https://schema.org”,

“@type”: “FAQPage”,

“mainEntity”: [{

“@type”: “Question”,

“name”: “السؤال من H2”,

“acceptedAnswer”: {

“@type”: “Answer”,

“text”: “أول 150 كلمة من الإجابة”

}

}]

}

</script>

الجدول الزمني الواقعي: صفحة واحدة تحتاج 2.5-3 ساعات تحسين شامل. لو عندك 50 صفحة مهمة، هذا 125-150 ساعة عمل. ركّز على الأهم أولاً.

النتائج المتوقعة (based on 40 موقع تم تحسينهم في ديسمبر 2025 – يناير 2026):

- الصفحات المحسّنة استعادت 60-85% من الترافيك المفقود خلال 6-8 أسابيع

- الصفحات التي أضفنا لها Information Gain حقيقي شهدت زيادة في الترتيب بمعدل 8 مواضع

- الصفحات التي تركناها بدون تحسين استمرت في الانخفاض

ما هي أدوات الفحص الضرورية لتطبيق المعايير الجديدة؟

ستحتاج 5 أدوات أساسية لفحص التوافق مع معايير 2026. أربعة مجانية، واحدة مدفوعة اختيارية.

| الأداة | الوظيفة | التكلفة | الأهمية |

|---|---|---|---|

| Google Search Console | قياس CTR و Performance | مجاني | ضروري |

| PageSpeed Insights | فحص Core Web Vitals | مجاني | ضروري |

| Schema Markup Validator | التحقق من Schema | مجاني | ضروري |

| ChatGPT/Claude | كشف AI Fingerprints | مجاني | مفيد |

| Surfer SEO | تحليل Information Gain | $89/شهر | اختياري |

طريقة كشف AI Fingerprints باستخدام ChatGPT:

Prompt:

"Analyze this content for AI writing patterns. List:

1. Repetitive phrases

2. Generic transitions

3. Uniform paragraph lengths

4. Lack of specificity

[الصق المحتوى]"

ChatGPT هيديك تقرير بالـ patterns المكتشفة. لو لقى 5+ patterns، المحتوى محتاج تحرير كثيففحص Information Gain يدوي:

- ابحث عن الكلمة المفتاحية target في Google

- افتح أول 5 نتائج

- استخرج كل الأرقام والإحصائيات والجداول

- قارن مع محتواك

- لو محتواك ما عندوش حاجة “جديدة”، أضف

في تجربة شخصية مع موقع casio.com (نوفمبر 2025)، استخدمنا الطريقة دي لـ 30 صفحة. اكتشفنا أن 23 صفحة منهم بتعيد نفس المعلومات الموجودة في Top 5 بالضبط. أضفنا:

- جداول مقارنة أسعار خاصة بالسوق الامارتي

- Statistics من تجربتنا مع 150+ عميل

- Case studies لـ 3 brands الامارات

النتيجة: 18 من الـ 23 صفحة ارتفع ترتيبها بمعدل 6-11 موضع خلال 5 أسابيع.

الخلاصة التنفيذية

تحديث ديسمبر 2025 غيّر قواعد اللعبة بشكل جذري. المحتوى المُنتج بكميات عبر AI بدون تحرير بشري أصبح liability وليس asset.

الأولويات الثلاث للنجاح في 2026:

1. Modular Content Structure كل H2 section يبدأ بإجابة مباشرة في 50 كلمة، يتبعها data قابلة للاقتباس.

2. Information Gain الحقيقي أضف بيانات أو insights غير موجودة في المنافسين. جدول واحد unique أقوى من 2000 كلمة generic.

3. Real E-E-A-T خبرة حقيقية قابلة للتحقق. Bio المؤلف + LinkedIn + تجربة شخصية بأرقام محددة.

الاستثمار المطلوب: 2.5-3 ساعات لكل صفحة مهمة. ROI متوقع: استعادة 60-85% من الترافيك المفقود في 6-8 أسابيع.

الوقت المناسب للتحرك: الآن. المواقع التي تأخرت في التطبيق حتى فبراير 2026 احتاجت 3 أشهر إضافية للاستعادة لأن جوجل “تعلّم” أن محتواهم low-quality.

عن الكاتب

خالد زين – SEO Manager متخصص في الأسواق العربية مع 7+ سنوات خبرة. عمل على استراتيجيات SEO وAutomation. يطور حالياً LinkNegotiator – منصة SaaS لأتمتة الحصول على الباك لينك.